مع ازدياد اعتماد العديد من المجالات الحيوية مثل الطب، المالية، القانون، وحتى القيادة الذاتية، على الذكاء الاصطناعي، أصبحت مسألة الثقة في قرارات هذه الأنظمة أمرًا جوهريًا.

المحاور الرئيسية:

التحدّي ببساطة

الشبكات العصبية العميقة Deep Neural Networks، التي تُعتبر العمود الفقري للعديد من تطبيقات الذكاء الاصطناعي، تعمل عادةً كـ “صندوق أسود” Black Box، مما يعني أن قراراتها وإجراءاتها تكون غامضة وغير مفهومة للبشر.

لا تستغرب أنها صندوق أسود، سنشرح لماذا لاحقاً.

وهذا يضعنا أمام تساؤل كبير هو: كيف يمكننا أن نثق في قرارات نظام ذكاء اصطناعي لا نفهم كيف يتخذها؟

هنا تأتي أهمية الشبكات العصبية القابلة للتفسير Explainable Neural Networks.

ربما تقول إن الشبكات العصبية هي في النهاية نماذج رياضية، وبالتالي يمكننا فهم سلوكها بكل بساطة، والجواب على الشكل التالي:

الشبكات العصبية هي بالفعل نماذج رياضية في جوهرها، حيث تعتمد على حسابات منطقية ورياضية مثل الضرب الجمعي، التفاضل، التكامل، وغيرها من العمليات الرياضية.

ومع ذلك، هناك عدة أسباب تجعل من الصعب فهم سلوكها ببساطة:

1- التعقيد الهائل:

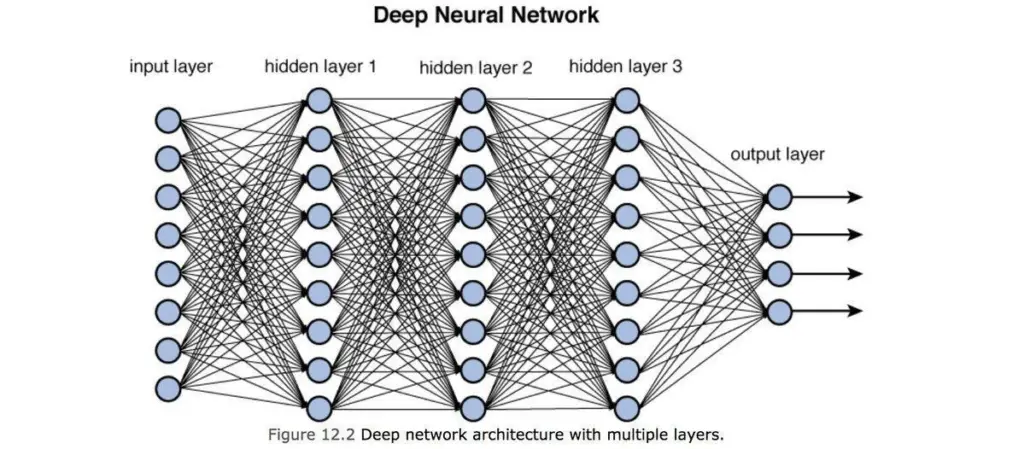

الشبكات العصبية العميقة تحتوي على عدد هائل من الوحدات العصبية (العصبونات) والروابط بين هذه العصبونات.

كل عصبون يقوم بإجراء حسابات معقدة بناءً على المدخلات التي يستقبلها، ويرسل النتيجة إلى العصبونات الأخرى.

عندما تتجاوز الشبكة عددًا معينًا من الطبقات والعصبونات، يصبح من المستحيل تقريبًا تتبع وفهم كيفية تأثير كل مدخل على المخرجات النهائية.

مثال:

إذا كانت الشبكة تحتوي على مليون عصبون موزعة على مئات الطبقات، فإن عدد الحسابات الممكنة والتفاعلات بين هذه العصبونات يتجاوز قدرة الإنسان على الفهم البسيط أو التتبع، حتى وإن كان ذلك كله رياضيات.

2- عدم الخطّية:

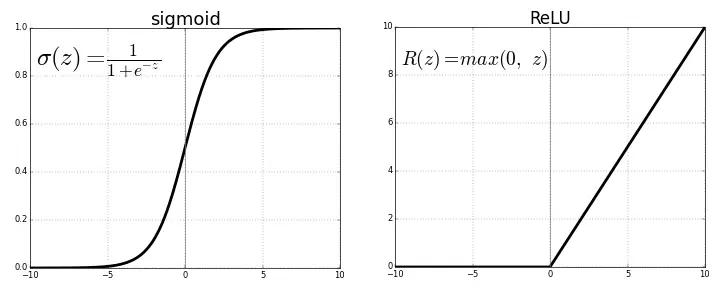

الشبكات العصبية تعتمد على دوال تنشيط غير خطية Non-linear Activation Functions مثل دالة ReLU أو Sigmoid.

هذه الدوال تضيف تعقيدًا إضافيًا لأن السلوك الرياضي للشبكة لا يمكن تمثيله ببساطة عبر علاقة خطية أو معادلة واحدة.

بدلاً من ذلك، يمكن أن تؤدي تغييرات طفيفة في المدخلات إلى تغييرات كبيرة وغير متوقعة في المخرجات.

مثال:

في نظام تصنيف الصور، يمكن لتغيير بكسل واحد في الصورة أن يؤدي إلى تغيير كبير في نتيجة التصنيف، وهذا بسبب عدم الخطية في الشبكة, هذا السلوك يصعب تحليله أو توقعه بشكل مباشر.

3- الصندوق الأسود:

الشبكات العصبية تعمل بشكل يشبه الصندوق الأسود لأننا لا نعرف كيف يتفاعل كل مكون داخلي (مثل العصبونات والروابط) مع الآخرين لإنتاج النتيجة النهائية.

قد نعرف المدخلات والمخرجات، لكن التفاصيل الدقيقة لكيفية وصول النموذج إلى قرار معين قد تكون غامضة.

مثال:

قد يتم تدريب نموذج للكشف عن الاحتيال المالي باستخدام ملايين من البيانات المالية. ومع ذلك، إذا قرر النموذج أن معاملة معينة مشبوهة، سيكون من الصعب تحديد السبب الدقيق لهذا القرار بدون أدوات تفسيرية.

4- التحيّزات المعقدة Neural Networks Bias:

الشبكات العصبية قد تتعلّم تحيّزات معقدة من البيانات التي تُدرب عليها.

هذه التحيّزات ليست واضحة دائمًا، وقد تؤدي إلى نتائج غير عادلة أو غير متوقعة. بدون أدوات تفسير، يمكن أن يكون من المستحيل تحديد هذه التحيّزات وتصحيحها.

مثال:

في نظام توظيف يعتمد على الذكاء الاصطناعي، قد يتعلم النموذج تحيّزًا ضد مرشحين من خلفيات معينة بناءً على البيانات السابقة. بدون تفسير واضح للقرارات، يمكن أن يستمر هذا التحيز دون أن يلاحظه أحد.

خلاصة الصندوق الأسود:

على الرغم من أن الشبكات العصبية هي في النهاية نماذج رياضية، إلا أن تعقيدها، عدم خطيتها، وطبيعتها كصندوق أسود يجعل من الصعب فهم سلوكها ببساطة.

هذا هو السبب في أن العلماء والمطورين يعملون على تطوير أدوات وأساليب تفسيرية تساعد على فهم القرارات التي تتخذها هذه النماذج، مما يجعلها أكثر شفافية وموثوقية في الاستخدامات الحساسة.

ما هي الشبكات العصبية القابلة للتفسير Explainable Neural Networks؟

قبل أن نفهم ما هي الشبكات العصبية القابلة للتفسير، من المهم أن نفهم أولاً كيف تعمل الشبكات العصبية التقليدية.

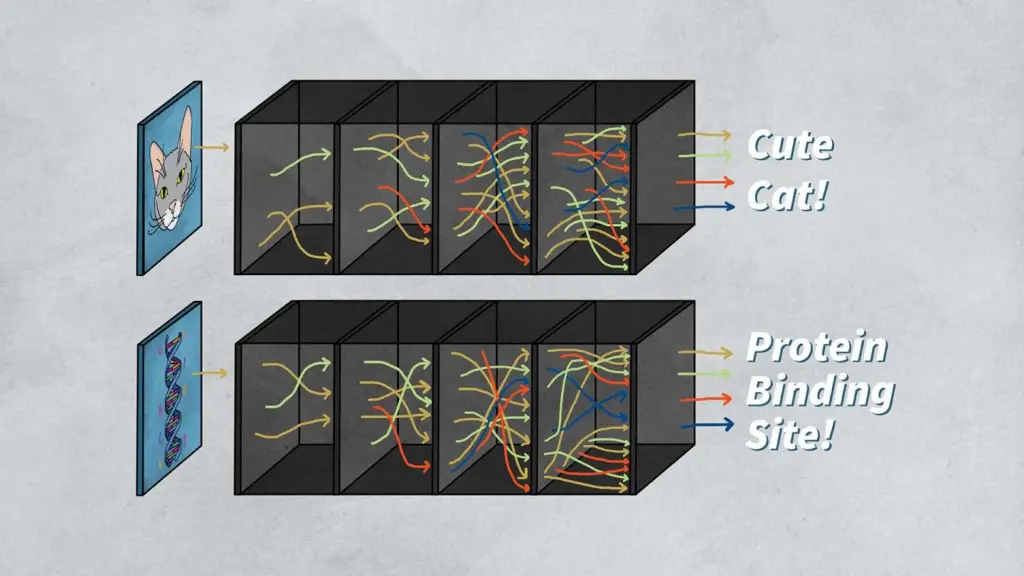

الشبكات العصبية التقليدية تشبه عقل الإنسان إلى حد ما, تتكون من عدة طبقات من العصبونات الاصطناعية التي تتلقى إشارات من المدخلات (مثل الصور، النصوص، البيانات)، ثم تقوم بمعالجتها عبر طبقات متعددة للوصول إلى مخرجات معينة (مثل التعرف على صورة كقطة أو كلب، أو التنبؤ بسعر السهم).

لكن أين المشكلة؟

المشكلة تكمن في أن عملية اتخاذ القرار التي تحدث داخل هذه الطبقات العديدة هي معقدة جدًا لدرجة أن حتى العلماء والمبرمجين الذين قاموا بتطوير هذه النماذج قد لا يستطيعون تفسير كيف توصل النموذج إلى نتيجة معينة.

على سبيل المثال، إذا أخبرك الذكاء الاصطناعي أن هناك احتمالية كبيرة بأن شخصًا ما يعاني من مرض معين، قد لا تكون قادرًا على فهم سبب هذا التشخيص.

وهذا يجعل من الصعب الثقة في قرارات هذه الأنظمة، خاصة عندما يتعلق الأمر بمسائل حياتية مثل الصحة أو المال.

لماذا نحتاج إلى تفسير قرارات الذكاء الاصطناعي؟

لنأخذ مثالاً بسيطًا:

تخيل أن هناك طبيبًا يعتمد على نظام ذكاء اصطناعي لتشخيص مرض ما.

هذا النظام يأخذ صورًا من الأشعة السينية للمريض، ثم يقدم تقريرًا مفاده أن المريض يعاني من مرض نادر في الرئتين.

إذا سأل الطبيب: “لماذا تعتقد أن المريض يعاني من هذا المرض؟”، فإن الشبكة العصبية التقليدية قد لا تكون قادرة على تقديم تفسير واضح.

في هذا السيناريو، إذا لم يتمكن الطبيب من فهم كيف توصّل النظام إلى هذا الاستنتاج، فقد يواجه صعوبة في الثقة به.

وهنا يأتي دور الشبكات العصبية القابلة للتفسير:

هذه الشبكات مصممة لتقديم تفسيرات واضحة ومفهومة لقراراتها.

إنها تقدم معلومات مثل “لقد استندت في قراري إلى هذه النقاط المحددة في صورة الأشعة السينية”، أو “لقد رأيت نمطًا معينًا في البيانات يشبه حالة مشابهة تم تدريب النموذج عليها”.

كيف تعمل الشبكات العصبية التقليدية؟

قبل أن ننتقل إلى كيف تعمل الشبكات العصبية القابلة للتفسير، من المفيد أن نفهم بشكل مبسط كيف تعمل الشبكات العصبية التقليدية.

الشبكة العصبية تعمل عن طريق تمرير البيانات عبر سلسلة من الطبقات المتصلة.

كل طبقة تحتوي على عصبونات (Nodes) تقوم بمعالجة جزء من البيانات. عندما يتم إدخال البيانات (مثل صورة أو نص) إلى الشبكة العصبية، يتم تمريرها عبر هذه الطبقات، حيث يتم إجراء عمليات حسابية على كل جزء من البيانات.

وهذا فيديو قصير وتوضيحي للآلية وبشكل مبسط قدر المستطاع.

خطوات أساسية في الشبكة العصبية:

- المدخلات Input: البيانات الأولية التي يتم إدخالها إلى الشبكة، مثل صورة أو نص.

- الطبقات المخفية Hidden Layers: تقوم بمعالجة البيانات بطرق مختلفة من خلال استخدام الأوزان (Weights) والتحيزات (Biases).

- المخرجات Output: النتيجة النهائية، مثل تصنيف صورة على أنها قطة أو كلب.

تحدي “الصندوق الأسود” في الشبكات العصبية التقليدية:

المشكلة في هذه العملية هي أنه، على الرغم من أننا نفهم كيف تمر البيانات عبر الشبكة، إلا أنه من الصعب جدًا تفسير ما الذي يجعل الشبكة تتخذ قرارات معينة في النهاية.

لماذا قررت الشبكة أن هذه الصورة هي صورة قطة وليست كلبًا؟ لماذا قررت أن هذه المريضة لديها مرض معين وليست مريضة أخرى؟

هذا هو ما يجعل الشبكات العصبية التقليدية تعمل كـ”صندوق أسود”، حيث نعرف المدخلات ونعرف المخرجات، ولكن لا نعرف ما يحدث بالضبط بينهما.

كيف يمكن جعل الشبكات العصبية قابلة للتفسير؟

هناك عدة طرق تُستخدم لجعل قرارات الشبكات العصبية أكثر قابلية للتفسير. دعونا نتناول بعضها مع أمثلة بسيطة.

1- التصوّر Visualization:

إحدى الطرق لجعل الشبكات العصبية أكثر شفافية هي من خلال التصوّر.

يمكننا إنشاء صور توضّح ما الذي “يركّز” عليه النموذج عندما يحاول اتخاذ قرار.

على سبيل المثال، إذا كانت الشبكة العصبية تحاول تحديد ما إذا كانت صورة معينة تحتوي على قطة، يمكننا إنشاء خريطة حرارية (Heatmap) توضح المناطق التي تركز عليها الشبكة العصبية.

2- النماذج المبسطة المحلية Local Simplified Models:

أسلوب آخر لجعل الشبكات العصبية أكثر تفسيرًا هو استخدام النماذج المبسطة المحلية. LIME Local Interpretable Model-agnostic Explanations

هو أداة تُستخدم لتفسير قرارات النموذج عن طريق بناء نموذج بسيط يمكن تفسيره محليًا (حول نقطة بيانات معينة).

بمعنى آخر، إذا أعطاك الذكاء الاصطناعي قرارًا معينًا، يمكن أن يستخدم LIME لبناء نموذج بسيط حول هذا القرار فقط ليشرح لك سبب اتخاذه.

مثال:

إذا قام الذكاء الاصطناعي بإخبارك أن هناك احتمالًا كبيرًا لأن ينجح منتج معين في السوق، يمكن أن يُظهر لك LIME العوامل التي يعتمد عليها النموذج في اتخاذ هذا القرار، مثل تفضيلات المستهلكين أو اتجاهات السوق الأخيرة.

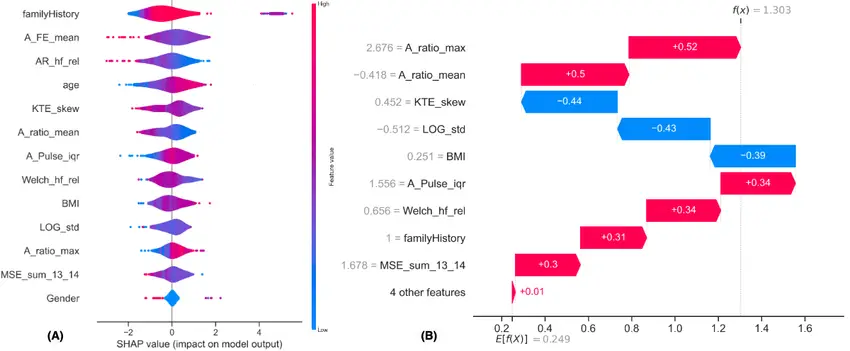

تحليل الأهمية باستخدام SHAP:

SHAP SHapley Additive exPlanations هو أسلوب آخر يعتمد على نظرية الألعاب لتخصيص قيمة لكل عنصر في البيانات بناءً على مساهمته في القرار النهائي للنموذج.

هذا يعني أنه يمكنك أن ترى كيف يؤثر كل عنصر في البيانات (مثل كل ميزة أو خاصية) على القرار النهائي.

مثال:

إذا كان لديك نموذج ذكاء اصطناعي يحاول التنبؤ بإمكانية إصابة شخص معين بمرض السكري، يمكن لـ SHAP أن يخبرك بأن عامل العمر له تأثير كبير، بينما عامل الوزن له تأثير أقل.

متى تكون الشبكات العصبية القابلة للتفسير مفيدة؟

الشبكات العصبية القابلة للتفسير ليست مفيدة فقط في مجال واحد، بل تمتد فائدتها إلى عدة مجالات مهمة:

1- الرعاية الصحية:

في مجال الطب، قد يستخدم الأطباء أنظمة ذكاء اصطناعي لمساعدتهم في تشخيص الأمراض.

لكن قبل أن يعتمد الطبيب على النظام بشكل كامل، يحتاج إلى فهم لماذا يعتقد النظام أن المريض مصاب بمرض معين. إذا كان النظام قادرًا على تقديم تفسير واضح ومفهوم، فإن الطبيب سيكون أكثر ثقة في استخدامه.

2- القطاع المالي:

في البنوك وشركات التأمين، يُستخدم الذكاء الاصطناعي في اتخاذ قرارات حول منح القروض أو تقييم المخاطر.

الشبكات العصبية القابلة للتفسير يمكن أن تساعد هذه المؤسسات على تقديم تفسيرات واضحة لقراراتها، مما يعزز من الشفافية والثقة بين العميل والمؤسسة.

3- السيارات ذاتية القيادة:

السيارات ذاتية القيادة تعتمد على الشبكات العصبية لاتخاذ قرارات في الوقت الحقيقي. من المهم أن تكون هذه القرارات قابلة للتفسير حتى يتمكن السائقون والجهات التنظيمية من فهم كيفية اتخاذ السيارة لقراراتها، خاصة في المواقف الحرجة.

التحديات في تفسير الشبكات العصبية

1- التوازن بين الدقة والتفسير:

واحدة من أكبر التحديات التي تواجه الشبكات العصبية القابلة للتفسير هي تحقيق التوازن بين القدرة على التفسير ودقة النموذج.

النماذج الأكثر تعقيدًا التي تحتوي على عدد أكبر من الطبقات والعصبونات تكون عادةً أكثر دقة في التنبؤات، لكنها في نفس الوقت تصبح أقل قابلية للتفسير.

على الجانب الآخر، النماذج الأبسط التي يمكن تفسيرها بسهولة، قد لا تقدم نفس مستوى الدقة في القرارات.

مثال:

تخيل أنك تستخدم نموذجًا معقدًا للتنبؤ بسعر العقارات.

قد يكون هذا النموذج دقيقًا للغاية لأنه يأخذ في الاعتبار العديد من العوامل، مثل الموقع، مساحة العقار، والقرب من المرافق العامة.

ومع ذلك، عندما تسأل “لماذا تم تقدير هذا السعر بالذات؟”، قد لا يتمكن النموذج من تقديم تفسير بسيط وواضح لكل عنصر من هذه العناصر، مما يجعل من الصعب فهم كيفية اتخاذ القرار النهائي.

2- التلاعب والتحيّز Bias:

تفسير النماذج ليس فقط حول فهم القرارات، بل يتعلق أيضًا بالتأكد من أن القرارات لا تتأثر بتحيزات غير مقصودة.

على سبيل المثال، إذا كان نموذج ما يتخذ قرارات بناءً على بيانات منحازة، فإن التفسيرات التي يقدمها قد تكون أيضًا منحازة.

مثال:

إذا كان نموذج الذكاء الاصطناعي المستخدم في عمليات التوظيف قد تم تدريبه على بيانات تاريخية تحتوي على تحيزات حول الجنس ذكر أم أنثى أو عرقية، فإن التفسيرات التي يقدمها قد تكون غير عادلة.

يجب أن يكون النموذج القابل للتفسير قادرًا على الكشف عن مثل هذه التحيزات وتصحيحها لضمان اتخاذ قرارات عادلة وموضوعية.

3- التعقيد الحسابي:

عملية تفسير الشبكات العصبية العميقة يمكن أن تكون مكلفة من حيث الوقت والحسابات.

بعض تقنيات التفسير مثل LIME أو SHAP تتطلب موارد حسابية إضافية لأنها تعتمد على بناء نماذج مبسطة أو حساب قيم إضافية لكل ميزة من ميزات البيانات.

مثال:

في مجال الرعاية الصحية، حيث الوقت قد يكون حاسمًا، فإن استغراق وقت طويل لتفسير قرار الذكاء الاصطناعي قد يكون غير عملي.

لذلك، من المهم أن تكون أدوات التفسير سريعة وفعالة بما يكفي لاستخدامها في الوقت الفعلي.

تطبيقات الشبكات العصبية القابلة للتفسير في الحياة اليومية

1- الرعاية الصحية:

الشبكات العصبية القابلة للتفسير تُستخدم في الرعاية الصحية لتقديم تفسيرات واضحة للأطباء حول قرارات التشخيص والعلاج.

على سبيل المثال، يمكن لنموذج ذكاء اصطناعي أن يقترح خطة علاج معينة لمريض بناءً على البيانات الطبية الخاصة به، مع تقديم تفسيرات مفصلة للطبيب حول السبب وراء هذا الاقتراح.

مثال:

إذا كان نموذج الذكاء الاصطناعي يقترح علاجًا محددًا لحالة مرضية نادرة، يمكنه أن يقدم للطبيب معلومات تفصيلية مثل “هذا العلاج تم اختياره بناءً على تاريخ المريض الطبي، نتائج الفحوصات المخبرية، وأنماط مماثلة تم ملاحظتها في مرضى آخرين”.

2- التجارة الإلكترونية:

في التجارة الإلكترونية، يمكن استخدام الشبكات العصبية القابلة للتفسير لفهم لماذا يقوم الذكاء الاصطناعي بتوصية منتجات معينة للعملاء.

على سبيل المثال، إذا كان نظام التوصية يقترح منتجًا معينًا لمشتري، يمكن للنظام أن يشرح السبب وراء هذه التوصية، مثل “استنادًا إلى مشترياتك السابقة واهتماماتك، نعتقد أنك ستعجب بهذا المنتج”.

مثال:

إذا كان نموذج الذكاء الاصطناعي يقترح على أحد العملاء شراء هاتف ذكي معين، يمكنه أن يوضح بأن السبب هو أن العميل اشترى سابقًا ملحقات تتوافق مع هذا الهاتف أو أن المستخدمين الذين لديهم تفضيلات مشابهة قاموا بشراء هذا الهاتف وأحبوه.

3- التعليم:

في قطاع التعليم، يمكن استخدام الشبكات العصبية القابلة للتفسير لمساعدة المدرسين على فهم كيفية تخصيص التعلم لكل طالب.

يمكن للنماذج تفسير سبب اقتراح استراتيجيات تعلم معينة بناءً على أداء الطالب في الاختبارات السابقة وبيانات أخرى.

مثال:

إذا كان النظام يقترح منهجًا تعليميًا محددًا لطالب معين، يمكن للنظام أن يشرح بأن هذه التوصية جاءت بناءً على نقاط القوة والضعف التي أظهرها الطالب في الاختبارات السابقة، وأنماط تعلمه السابقة.

التطورات المستقبلية في الشبكات العصبية القابلة للتفسير

مع استمرار الأبحاث في مجال الذكاء الاصطناعي، يُتوقع أن تصبح الشبكات العصبية القابلة للتفسير أكثر تطورًا وفعالية في المستقبل. من المتوقع أن تركز هذه التطورات على:

1- تطوير نماذج هجينة Hybrid models:

تطوير نماذج هجينة تجمع بين دقة الشبكات العصبية العميقة وقابلية التفسير للنماذج التقليدية. هذه النماذج يمكن أن توفر توازنًا بين الأداء والتفسير.

مثال:

يمكن استخدام هذه النماذج في مجالات مثل السيارات ذاتية القيادة، حيث يتطلب اتخاذ قرارات دقيقة في الوقت الحقيقي، مع تقديم تفسيرات واضحة في حالة حدوث أي خلل.

2- تقليل التحيّزات Bias:

تحسين قدرة الشبكات العصبية على الكشف عن التحيزات وتصحيحها بشكل تلقائي. سيؤدي ذلك إلى اتخاذ قرارات أكثر عدلاً وموضوعية، خاصة في المجالات الحساسة مثل العدالة والتوظيف.

3- زيادة سرعة التفسير:

تطوير أدوات تفسير أسرع وأكثر كفاءة، مما يسمح باستخدامها في الوقت الفعلي حتى في البيئات الحساسة زمنياً مثل الرعاية الصحية.

أمثلة على برمجيات لجعل الشبكات العصبية قابلة للتفسير

فيما يلي بعض الأمثلة البارزة على منتجات وبرمجيات طورتها شركات معروفة لجعل الشبكات العصبية العميقة أكثر تفسيرًا وشفافية:

1- منتج What-If Tool من Google:

Google طورت أداة تسمى What-If Tool، وهي أداة بصرية تساعد على تفسير قرارات النماذج التي تعتمد على التعلم العميق.

توفر الأداة واجهة تفاعلية تتيح للمستخدمين تعديل المدخلات ورؤية كيف يؤثر ذلك على قرارات النموذج.

يمكن استخدامها لفحص النتائج التي يولدها النموذج وتحديد كيفية تأثير الخصائص المختلفة على هذه النتائج. يتم تضمين هذه الأداة في منصة TensorFlow الخاصة بـ Google.

مثال:

إذا كنت تستخدم نموذجًا لتوقع مستوى أداء الطلاب بناءً على عوامل مثل العمر وساعات الدراسة والدرجات السابقة، يمكن للأداة أن تظهر لك كيف أن تغيير إحدى هذه المتغيرات يؤثر على التوقعات.

على سبيل المثال، يمكنك تعديل عدد ساعات الدراسة لترى كيف تتغير التوقعات إذا كان الطالب يدرس لساعات أطول.

2- أداة InterpretML من Microsoft:

InterpretML هي مكتبة مفتوحة المصدر طورتها Microsoft لتقديم تفسيرات واضحة للنماذج المعقدة مثل الشبكات العصبية.

توفر هذه المكتبة أدوات متعددة للتفسير، مثل SHAP وLIME، وتتيح للمطورين تحليل كيفية اتخاذ النماذج لقراراتها. يمكن دمج InterpretML بسهولة مع النماذج في Azure Machine Learning أو أي بيئة أخرى.

مثال:

في حالة تطبيق التصنيف الطبي، يمكن استخدام InterpretML لفهم كيف توصل النموذج إلى تشخيص معين. قد يساعد هذا الأطباء في فهم الأسباب الكامنة وراء توصيات النموذج وتشخيصاته، مما يجعل القرارات أكثر شفافية ويزيد من الثقة فيها.

3- أداة AI Explainability 360 من IBM:

طورت IBM مجموعة أدوات مفتوحة المصدر تسمى AI Explainability 360، والتي توفر أدوات لشرح القرارات التي تتخذها نماذج الذكاء الاصطناعي.

تركز هذه الأدوات على تحسين الشفافية في التطبيقات الحساسة مثل الرعاية الصحية والتمويل. تم تصميم AIX 360 ليكون متكاملًا مع منصات مثل IBM Watson.

مثال:

في حالة استخدام نظام ذكاء اصطناعي للتوصية بالاستثمارات المالية، يمكن لأداة AIX 360 تقديم تفسير واضح للمستثمرين حول سبب اختيار النموذج لاستثمار معين بناءً على تحليله للبيانات الاقتصادية.

4- أداة Captum من Facebook:

Captum هو مكتبة مفتوحة المصدر طورتها Facebook لتوفير أدوات تفسير للشبكات العصبية العميقة المدربة باستخدام PyTorch.

Captum يقدم طرقًا مختلفة لتفسير قرارات النماذج، مثل Integrated Gradients وDeepLIFT. توفر هذه الأدوات تحليلات مفصلة حول أهمية كل ميزة وكيفية تأثيرها على مخرجات النموذج.

مثال:

في سياق تحليل النصوص، إذا كان نموذج الذكاء الاصطناعي يصنف تغريدات تويتر كمحتوى إيجابي أو سلبي، يمكن لـ Captum توضيح الكلمات التي اعتبرها النموذج مفتاحية في اتخاذ قراره. هذا يساعد في تحسين الفهم والموثوقية في تصنيف المشاعر أو تحليل النصوص.

خلاصة مهمة

الشبكات العصبية القابلة للتفسير تمثل أحد أهم التطورات في مجال الذكاء الاصطناعي، حيث تجمع بين قوة النماذج العميقة وقدرتها على تقديم تفسيرات واضحة ومفهومة.

لا ننسى أن أحد الأبواب العريضة المفتوحة للتطوير والكل بحاجة لها هي بناء أدوات تفسير سلوك الشبكات العصبية العميقة، وهنا يكمن الكثير من الأفكار لمنتجات تجارية وشركات ناشئة تقنية.

وعلى الرغم من التحديات التي تواجه هذا المجال، فإن التحسينات المستمرة والتطبيقات العملية تجعلها أحد المجالات الأكثر أهمية في تطوير الذكاء الاصطناعي الموثوق به والمسؤول.

تقوم هذه الشركات بتطوير أدوات وبرمجيات تهدف إلى جعل الشبكات العصبية أكثر تفسيرًا، مما يساعد في تعزيز الثقة في أنظمة الذكاء الاصطناعي المستخدمة في المجالات الحساسة.

هذه الأدوات ليست فقط للخبراء في التعلم العميق، بل يمكن استخدامها من قبل الأشخاص غير المتخصصين لفهم قرارات النماذج بشكل أفضل وتجنب المخاطر المحتملة المرتبطة بالاعتماد على الصناديق السوداء.