إن المنظمات التي تطور أنظمة الذكاء الاصطناعي تعلم أن ذلك ينطوي على مجموعة متنوعة من المخاطر بما في ذلك العواقب القانونية والتنظيمية.

وقد تحصل أضرار محتملة تلحق بسمعة هذه الشركات أو المنظمات، منها ما هو قضايا أخلاقية مثل التحيز والافتقار إلى الشفافية.

كما تعلم المنظمات أنه من خلال الحوكمة الرشيدة، يمكنها التخفيف من المخاطر وضمان تطوير أنظمة الذكاء الاصطناعي واستخدامها بشكل مسؤول.

وتهدف الحوكمة الرشيدة إلى ضمان أن تكون الأنظمة عادلة وشفافة وخاضعة للمساءلة ومفيدة للمجتمع.

الكثير يعتقد أن هذه الحوكمة بعيدة المنال، ولكن الخطى الحثيثة لذلك تظهر أننا نقترب كثيراً من حوكمة شاملة ستننظم آلية فهم واكتشاف المخاطر وتجاوزها.

المحاور الرئيسية:

ما هي إدارة مخاطر الذكاء الاصطناعي؟

إدارة مخاطر الذكاء الاصطناعي AI risk management هي عملية تحديد المخاطر المحتملة المرتبطة بتقنيات الذكاء الاصطناعي وتخفيفها ومعالجتها بشكل منهجي.

وهي تنطوي على مجموعة من الأدوات والممارسات والمبادئ، مع التركيز بشكل خاص على نشر أطر إدارة مخاطر الذكاء الاصطناعي الرسمية.

بشكل عام، يتمثل هدف إدارة مخاطر الذكاء الاصطناعي في تقليل التأثيرات السلبية المحتملة للذكاء الاصطناعي مع تعظيم فوائده.

ما هي إدارة مخاطر وحوكمة الذكاء الاصطناعي؟

تعتبر إدارة مخاطر الذكاء الاصطناعي جزءًا من المجال الأوسع لحوكمة الذكاء الاصطناعي AI governance.

تشير حوكمة الذكاء الاصطناعي AI governance إلى الحواجز التي تضمن سلامة أدوات وأنظمة الذكاء الاصطناعي وأخلاقياتها وبقائها على هذا النحو.

تعتبر حوكمة الذكاء الاصطناعي تخصصًا شاملاً، في حين أن إدارة مخاطر الذكاء الاصطناعي هي عملية ضمن هذا التخصص.

تركز إدارة مخاطر الذكاء الاصطناعي بشكل خاص على تحديد نقاط الضعف والتهديدات ومعالجتها للحفاظ على أنظمة الذكاء الاصطناعي في مأمن من الأذى.

تنشئ حوكمة الذكاء الاصطناعي الأطر والقواعد والمعايير التي توجه أبحاث الذكاء الاصطناعي وتطويره وتطبيقه لضمان السلامة والإنصاف واحترام حقوق الإنسان.

ما هي المخاطر المتعلقة بأنظمة الذكاء الاصطناعي؟

على الرغم من أن كل نموذج وحالة استخدام للذكاء الاصطناعي يختلفان عن بعضهما البعض، فإن مخاطر الذكاء الاصطناعي تنقسم عمومًا إلى أربع فئات:

- مخاطر البيانات: مثل أمن البيانات، خصوصية البيانات، سلامة البيانات وصحتها، فقدان البيانات، انتهاك السرية …الخ.

- مخاطر النماذج: الهجمات العدائية، حقن الأوامر Prompt injections لأغراض تخريبية، قابلية التفسير وفقر الشفافية، …الخ.

- المخاطر التشغيلية: الانحراف وتدهور الأداء، إمكانية التوسع والاستدامة …الخ.

- المخاطر الأخلاقية والقانونية: الشفافية، التحيز, حقوق الانسان, فقد الثقة …الخ.

إذا لم تتم إدارتها بشكل صحيح، فقد تعرض هذه المخاطر أنظمة الذكاء الاصطناعي والمنظمات لأضرار جسيمة، بما في ذلك الخسائر المالية، والأضرار التي تلحق بالسمعة، والعقوبات التنظيمية، وتآكل الثقة العامة، وانتهاكات البيانات.

أشهر الأطر لإدارة مخاطر الذكاء الاصطناعي

تتعامل العديد من المنظمات مع مخاطر الذكاء الاصطناعي من خلال تبني أطر إدارة مخاطر الذكاء الاصطناعي، وهي عبارة عن مجموعات من المبادئ التوجيهية والممارسات لإدارة المخاطر عبر دورة حياة الذكاء الاصطناعي بالكامل.

بعض الأطر الأكثر استخدامًا هي:

- إطار عمل إدارة مخاطر الذكاء الاصطناعي التابع للمعهد الوطني للمعايير والتكنولوجيا NIST (النسخة العربية للمعيار).

- قانون الذكاء الاصطناعي في الاتحاد الأوروبي EU AI Act.

- معايير ISO/IEC.

- الأمر التنفيذي الأمريكي بشأن الذكاء الاصطناعي US executive order on AI.

وسنمر على بعض الأطر ونتوسع قليلاً بذكر محاولات أخرى جادّة من قبل الباحثين والمتخصصين في هذا المجال.

النموذج المرن لحوكمة الذكاء الاصطناعي المعتمد على الـ RMF

استناداً لما سبق من أهمية الحوكمة والتصنيف وتقييم المخاطر، قامت IEEE-USA AI Policy Committee بنشر النموذج المرن لحوكمة الذكاء الاصطناعي A Flexible Maturity Model for AI Governance .

وهو نموذج معتمد على منهجية إدارة المخاطر AI Risk Management Framework (RMF) المقدم من قبل المعهد الوطني للمعايير والتكنولوجيا في الولايات المتحدة الامريكية NIST.

رغم أن الإطار RMF يعتبر جيد جداً ولكنه يفتقر إلى الدليل العملي المفصّل للشركات والأفراد لتنفيذ هذا الإطار ويطرح امامهم العديد من الاستفسارات.

ولذا تم طرح النموذج المرن للنضوج A Flexible Maturity Model for AI لكي يكمل إطار الـ RMF ويضع النقاط على الحروف.

النموذج المرن للنضوج، يضع الخطوات اللازمة للوصول إلى حوكمة ناضجة مع معايير قياس واضحة للمؤسسات خلال رحلتها وخارطة طريق جيدة ترسم لهم الخطوات اللازمة.

الأعمدة الرئيسية للنموذج

يعتمد النموذج على أربعة أعمدة رئيسية:

- التحديد Map: يتم تحديد السياق والمخاطر المحتملة.

- القياس Measure: يتم تقييم وتحليل المخاطر المكتشفة.

- الإدارة Manage: تُحدد الأولويات ويتم اتخاذ إجراءات للحد من المخاطر بناءً على تأثيرها المحتمل.

- الحوكمة Govern: يتم إنشاء ثقافة إدارة المخاطر ضمن المنظمة.

هذه الأعمدة تمكّن المنظمات من قياس مستوى نضجها في حوكمة الذكاء الاصطناعي وتحديد مجالات التحسين.

كيف يتم الامتثال للنموذج المرن في الحوكمة؟

ستتضح مرونة النموذج من خلال فهم عمله وكيف للشركة او المنظمة ان تمتثل له، لنبدأ بمثال ومن ثم نجمع الأمور مع بعضها.

لنفترض أن الشركة تدّعي ان نموذجها اللغوي عادل في إجاباته.

هذه الادعاء يقابله عبارة لنسميها Statement تأتي من قبل النموذج المرن على الشكل التالي:

لو كان النموذج عادل، فيجب ان لا يحوي أي تحيز ويكون منصف، ولتحقيق ذلك، يجب ان نقيّم ونوثق الإجراءات التي تقوم بها الشركة ضمن نموذجها اللغوي لضمان ذلك.

الآن لنتخيل أن لدينا مجموعة كبيرة من الـ Statements مع بعضها البعض ومجتمعة لتشكل ما نسميه الاستبيان أو الـ questionnaire وهو ما يشكل نواة الإطار.

عند هذه النقطة دعونا نجمع الأمور مع بعضها، لنخرج بتعريف لطريقة عمل هذا الإطار.

يعمل النموذج الذكي على مراحل أساسية هي:

- التخطيط planning.

- التصميم design.

- جمع البيانات data collection.

- بناء النموذج model building.

- وأخيراً النشر deployment.

يمكن للمشرّع أن يقيم كل المراحل أو أحدها، ويضع الاستبيان questionnaire المناسب للمرحلة مع قائمة الـ Statements ليتم التقييم.

وهذا ما يجعله مرن بشكل جيد مع وضوح في آلية العمل بالإضافة إلى الانضباط تحت إطار العمل الـ RMF.

للمزيد من التفاصيل حول النموذج المرن لحوكمة الذكاء الاصطناعي A Flexible Maturity Model for AI Governance يرجى مراجعة الرابط التالي من هنا.

تصنيف مخاطر الذكاء الاصطناعي AIR 2024

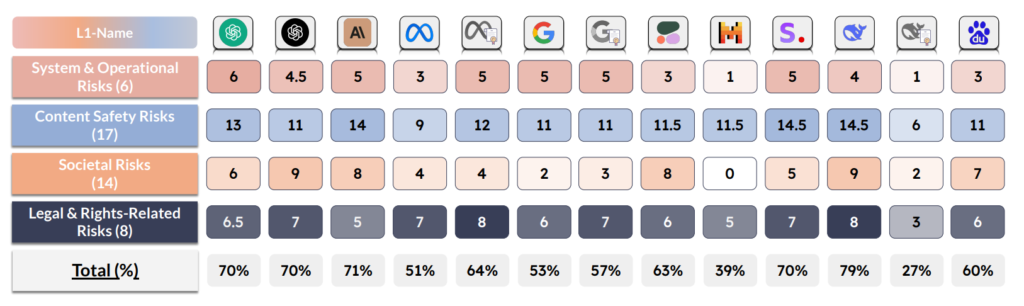

قامت مجموعة من الباحثين والمتخصصين في الذكاء الاصطناعي منهم Bo Li، الأستاذ المشارك في جامعة شيكاغو، وزملاء له من العديد من الجامعات الأخرى، بما في ذلك جامعة ستانفورد، بالإضافة إلى Virtue AI، التي شارك في تأسيسها Bo Li، وLapis Labs، بتطوير تصنيف لمخاطر الذكاء الاصطناعي إلى جانب معيار يكشف عن مدى انتهاك نماذج اللغة الكبيرة المختلفة للقواعد.

يقدم هذا التصنيف نظرة شاملة لمخاطر الذكاء الاصطناعي مستمدًا من ثماني سياسات حكومية من الاتحاد الأوروبي والولايات المتحدة والصين و16 سياسة لشركة في جميع أنحاء العالم.

وهذا بحد ذاته يشكّل خطوة مهمة نحو إنشاء لغة موحّدة لتقييم سلامة الذكاء الاصطناعي التوليدي.

يتضمن هذا التصنيف, 314 تصنيفاً او فئة categories فريدة unique من المخاطر، والتي بدورها تم تقسيمها إلى أربع طبقات.

تم تسمية هذا التصنيف بـ AI Risk Categorization Decoded (AIR 2024).

على سبيل المثال تحوي الطبقة الأعلى على أربع تصنيفات هي:

- التصنيف الأول: تشمل تصنيفات مخاطر النظام والتشغيل

- التصنيف الثاني: مخاطر سلامة المحتوى.

- التصنيف الثالث: المخاطر المجتمعية.

- التصنيف الرابع: المخاطر القانونية والحقوقية.

ونلاحظ في الصورة التالية كيف تم تقييم بعض النماذج طبقاً للطبقة الأعلى وتصنيفاتها:

ويمكن الاطلاع على تفاصيل أكثر حول باقي الطبقات وتصنيفاتها من هنا.

كما قام الباحثون نفسهم ببناء معيار الـ AIR-Bench 2024، وهو بحسب مؤسسوه أول معيار سلامة للذكاء الاصطناعي يتماشى مع اللوائح الحكومية وسياسات الشركات، باتباع فئات السلامة القائمة على التنظيم.

وهو يستند إلى دراسة مخاطر الذكاء الاصطناعي AI Risk Categorization Decoded المذكورة أعلاه.

يستخدم هذا المعيار آلاف المطالبات لتحديد مدى نجاح نماذج الذكاء الاصطناعي الشائعة من حيث المخاطر المحددة.

على سبيل المثال، يُظهر أن Claude 3 Opus من Anthropic يحتل مرتبة عالية عندما يتعلق الأمر برفض توليد تهديدات الأمن السيبراني، بينما يحتل Gemini 1.5 Pro من Google مرتبة عالية من حيث تجنب توليد عُري جنسي غير توافقي.

سجل DBRX Instruct، وهو نموذج طورته Databricks، أسوأ نتيجة على الإطلاق. عندما أصدرت الشركة نموذجها في مارس، قالت إنها ستواصل تحسين ميزات الأمان في DBRX Instruct.

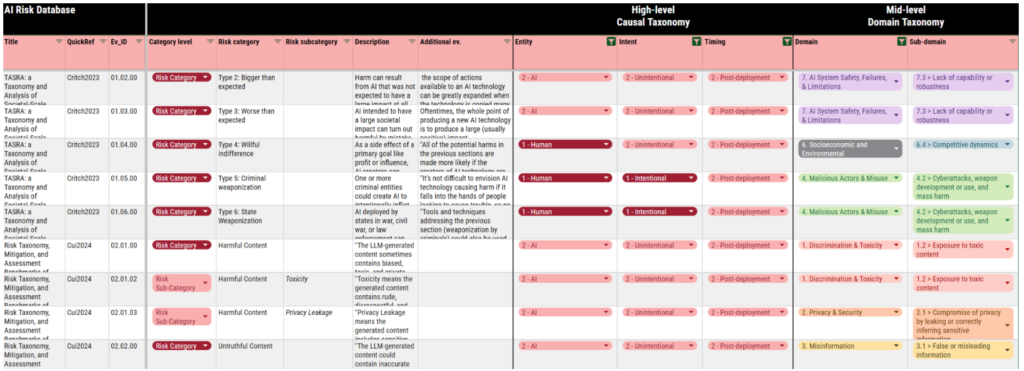

مستودع مخاطر الذكاء الاصطناعي

وهو قاعدة بيانات منظمة للغاية ومفتوحة للعموم مطورة من باحثي معهد MIT للتكنولوجيا، تحتوي على أكثر من 700 خطر للذكاء الاصطناعي مستخرج من 43 إطار عمل موجود، مع علامات اقتباس وأرقام الصفحات.

يصنّف التصنيف السببي لمخاطر الذكاء الاصطناعي كيفية حدوث هذه المخاطر ومتى ولماذا.

يصنف التصنيف المجالي لمخاطر الذكاء الاصطناعي هذه المخاطر إلى سبعة مجالات (على سبيل المثال، “المعلومات المضللة”) و23 مجالًا فرعيًا (على سبيل المثال، “المعلومات الكاذبة أو المضللة”).

الدافع وراء بناء هذا المستودع الكبير بحسب رأي المؤسسيين هو سد الفجوة في الافتقار إلى الفهم المشترك لمخاطر الذكاء الاصطناعي بين مجتمع الباحثين والمراجعين وصناع السياسات.

لبناء هذا المستودع، عمل باحثو معهد MIT للتكنولوجيا مع زملاء في جامعة University of Queensland، ومعهد مستقبل الحياة غير الربحي the nonprofit Future of Life Institute، وجامعة لوفين KU Leuven، وشركة Harmony Intelligence الناشئة في مجال الذكاء الاصطناعي، لفحص قواعد البيانات الأكاديمية واسترجاع آلاف الوثائق المتعلقة بتقييمات مخاطر الذكاء الاصطناعي.

ووجد الباحثون أن أطر العمل التابعة لجهات خارجية التي قاموا بدراستها ذكرت مخاطر معينة أكثر من غيرها.

على سبيل المثال، تضمنت أكثر من 70% من الأطر الآثار المترتبة على الخصوصية والأمن للذكاء الاصطناعي، في حين تناولت 44% فقط منها المعلومات المضللة.

وبينما ناقش أكثر من 50% أشكال التمييز والتحريف التي يمكن للذكاء الاصطناعي أن يقدمها، تحدث 12% فقط عن “تلوث النظام البيئي للمعلومات” أي يقصدون هنا ازدياد الـ Spam.

خلاصة مهمة للشركات العاملة في المجال

نعلم جميعاً أن تقنيات الذكاء الاصطناعي ليست خالية من المخاطر, حيث يمكن أن تصبح كل قطعة من تكنولوجيا المعلومات التي بنتها وطورتها الشركة إلى سلاح ضار لو وقعت الأيدي الخطأ.

لا تحتاج المؤسسات إلى تجنب الذكاء الاصطناعي، بل تحتاج ببساطة إلى التعامل معه مثل أي أداة تقنية أخرى. وهذا يعني فهم المخاطر واتخاذ خطوات استباقية لتقليل فرصة وقوع هجوم ناجح.