في عالم يتزايد فيه الاعتماد على الذكاء الاصطناعي (AI) والتعلم العميق (Deep Learning)، أصبحت الشبكات العصبية (Neural Networks) أدوات أساسية في مجالات متعددة مثل الرؤية الحاسوبية (Computer Vision) ومعالجة اللغة الطبيعية (Natural Language Processing).

على الرغم من قدراتها المذهلة، تواجه هذه النماذج تهديدات من نوع خاص تعرف بالهجمات العدائية (Adversarial Attacks).

سنتناول في هذه المقالة كيفية تعزيز متانة الشبكات العصبية لمواجهة هذه الهجمات.

المحاور الرئيسية:

ما هي الهجمات العدائية؟

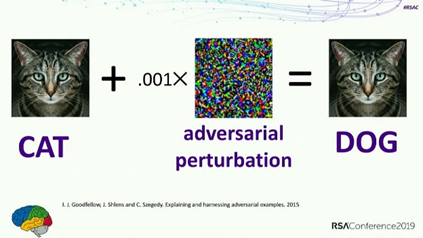

الهجمات العدائية هي محاولات لاستغلال نقاط الضعف في نماذج الذكاء الاصطناعي من خلال تقديم مدخلات معدلة بشكل طفيف ولكنها مضللة، مما يؤدي إلى توليد مخرجات خاطئة. يمكن أن تكون هذه الهجمات بسيطة، مثل إضافة ضوضاء غير مرئية تقريبًا إلى صورة، أو معقدة، مثل تعديل نص ليبدو طبيعيًا ولكنه يخدع النموذج.

هنا مرجع أكاديمي من مجموعة مختصين حول العالم لشرح الفكرة بتفاصيلها.

مثال على الهجمات العدائية:

تخيل نموذجًا تم تدريبه على التعرف على الحيوانات في الصور.

بإضافة ضوضاء صغيرة وغير مرئية إلى صورة قطة، يمكن للمهاجم تحويل نتيجة النموذج بحيث يعتقد أن الصورة تحتوي على كلب بدلاً من قطة.

هذا النوع من الهجمات قد يبدو بسيطًا، ولكنه يمثل تحديًا كبيرًا لأمان النماذج.

لماذا تعد الهجمات العدائية مشكلة؟

الأثر على الأمان والخصوصية:

الهجمات العدائية يمكن أن تؤدي إلى عواقب وخيمة في تطبيقات حقيقية مثل السيارات الذاتية القيادة (Autonomous Vehicles) وأنظمة التعرف على الوجوه (Facial Recognition Systems).

على سبيل المثال، يمكن أن يتم خداع نظام التعرف على الإشارات المرورية ليتعرف على إشارة توقف كإشارة سرعة، مما قد يؤدي إلى حوادث خطيرة.

الثقة في الذكاء الاصطناعي:

تؤثر الهجمات العدائية على ثقة المستخدمين في أنظمة الذكاء الاصطناعي. إذا كانت النماذج عرضة للهجمات بسهولة، فقد يفقد المستخدمون الثقة في التطبيقات التي تعتمد على هذه النماذج، مما يعرقل تبني التكنولوجيا على نطاق واسع.

كيف يمكن تعزيز متانة الشبكات العصبية؟

التدريب على الأمثلة العدائية (Adversarial Training):

التدريب على الأمثلة العدائية يتضمن إضافة أمثلة معدّلة عدائيًا إلى مجموعة التدريب.

يتم تعديل هذه الأمثلة بحيث تكون قادرة على خداع النموذج في البداية، ولكن مع التدريب المستمر، يصبح النموذج أكثر قدرة على التعرف على هذه الأنماط المضللة والتعامل معها بفعالية.

مثال:

لنفرض أن لدينا مجموعة بيانات تحتوي على صور للحيوانات. يمكننا تعديل بعض هذه الصور بشكل طفيف بحيث تكون قادرة على خداع النموذج، ثم نستخدم هذه الصور المعدلة في عملية التدريب لتحسين متانة النموذج.

مرجع للتعمق التقني والرياضي:

قدمت هذه الورقة العلمية عام 2015 أحد أقدم المناهج للتدريب على الأمثلة العدائية.

الدفاع بالاعتماد على الخصائص الإحصائية (Statistical Property-Based Defenses):

بعبارة مختصرة، سوف نشكك في البيانات لنكتشف أي شذوذ يدلنا على أنه تم تشويهها عمداً أم لا.

يتضمن هذا النهج تحليل الخصائص الإحصائية للنماذج والبيانات لتحديد الأنماط غير الطبيعية التي قد تشير إلى هجمات عدائية.

يمكن استخدام تقنيات مثل تحليل المكونات الرئيسية (Principal Component Analysis – PCA) والتعلم العميق للكشف عن الشذوذ (Anomaly Detection) لتحقيق ذلك.

مثال:

يمكن استخدام تحليل المكونات الرئيسية لتحديد الصور التي تحتوي على أنماط ضوضاء غير طبيعية، مما يشير إلى احتمال تعرضها لهجوم عدائي.

مرجع مهم:

قدمت هذه الورقة عام 2018 طرقًا متعددة للدفاع بالاعتماد على الخصائص الإحصائية.

التعلم العميق الدفاعي (Defensive Deep Learning):

يتضمن التعلم العميق الدفاعي تطوير نماذج مخصصة للدفاع تكون أكثر مقاومة للهجمات العدائية. يمكن أن تشمل هذه النماذج شبكات عصبية مخصصة لتحليل النصوص أو الصور قبل تمريرها إلى النموذج الرئيسي، أو استخدام شبكات معمارية جديدة تكون بطبيعتها أكثر متانة ضد الهجمات.

مثال:

يمكن تطوير شبكة عصبية تعمل كمرشح أولي لتحليل الصور وتحديد تلك التي قد تحتوي على تعديلات عدائية قبل تمريرها إلى النموذج الرئيسي.

مراجع:

قدمت هذه الورقة عام 2015 كيفية تحسين متانة الشبكات العصبية باستخدام تقنيات التعلم العميق الدفاعي.

التطبيقات العملية لتعزيز المتانة

السيارات ذاتية القيادة:

في تطبيقات السيارات الذاتية القيادة، يمكن استخدام التدريب على الأمثلة العدائية لتحسين قدرة النماذج على التعرف على الإشارات المرورية في ظروف غير مثالية، مثل الضباب أو الإضاءة المنخفضة.

الأنظمة المالية:

وهنا يمكن استخدام الدفاع بالاعتماد على الخصائص الإحصائية لاكتشاف الاحتيال في المعاملات المالية.

من خلال تحليل الأنماط السلوكية للمستخدمين، يمكن تحديد العمليات التي قد تكون مشبوهة.

الأنظمة الطبية:

يمكن استخدام التعلم العميق الدفاعي لتحليل الصور الطبية وتحديد الأنماط التي قد تشير إلى تحوير عدائي، مما يضمن دقة التشخيصات الطبية.

التحديات المستمرة والبحوث المستقبلية

التحديات المستمرة:

على الرغم من التقدم الكبير في تحسين متانة الشبكات العصبية، لا تزال هناك تحديات قائمة. تتطلب الهجمات العدائية الجديدة تقنيات دفاعية أكثر تطورًا، مما يستدعي بحوثًا مستمرة لتطوير أساليب دفاعية مبتكرة.

البحوث المستقبلية:

تشمل البحوث المستقبلية تطوير تقنيات جديدة مثل التعلم العميق التكيفي (Adaptive Deep Learning) والذي يمكنه التكيف مع الهجمات العدائية في الوقت الحقيقي.

بالإضافة إلى ذلك، يجري العمل على تطوير نماذج هجينة تجمع بين الأساليب الدفاعية المختلفة لتحقيق متانة أفضل.

الخاتمة

تمثل الهجمات العدائية تهديدًا حقيقيًا لمتانة الشبكات العصبية وتطبيقات الذكاء الاصطناعي بشكل عام.

من خلال استخدام تقنيات مثل التدريب على الأمثلة العدائية، والدفاع بالاعتماد على الخصائص الإحصائية، والتعلم العميق الدفاعي، يمكن تحسين متانة هذه النماذج وجعلها أكثر قدرة على مواجهة التحديات الأمنية.

تظل البحوث المستمرة والتطوير المستمر مفتاحًا لضمان أمان وفعالية هذه النماذج في المستقبل.