تصور لوهلة وجود وحدات معالجة قادرة على التفكير مثل الدماغ البشري، وتعمل على أجهزة بحجم راحة يدك.

هل أنت مستعد لاستكشاف ثورة وحدات المعالجة العصبية التي ستعيد تعريف عالم التكنولوجيا؟

المحاور الرئيسية:

تمهيد مهم

لنتمعّن قليلاً, الأجهزة الصغيرة التي نستخدمها يوميًا مثل الهواتف الذكية، الساعات الذكية، والكاميرات الأمنية، قادرة اليوم على التفكير واتخاذ القرارات بشكل شبه فوري.

كيف يمكن أن يحدث هذا؟ ما القوة التي تجعل هذه الأجهزة قادرة على تنفيذ مهام معقدة مثل التعرف على الوجه أو تحليل البيانات في الوقت الحقيقي دون الحاجة إلى اتصال دائم بالسحابة أو مراكز البيانات؟

هنا تكمن الثورة في عالم التكنولوجيا، إنها وحدات المعالجة العصبية Neural Processing Units – NPUs.

هذه الوحدات المتقدمة ليست مجرد تحسينات تقنية، بل تمثل قفزة نوعية في مجال الذكاء الاصطناعي.

هل أنت مستعد للغوص في أعماق هذه الثورة الجديدة؟ دعنا نبدأ معًا في اكتشاف القوة الحقيقية خلف المعالجة العصبية وكيفية تأثيرها على مستقبل الذكاء الاصطناعي.

تعريف مهم، ما هي المعالجة على الحافة Edge Computing

هذا المصطلح يعني إجراء عمليات معالجة البيانات بالقرب من مصدر البيانات نفسه، بدلاً من إرسال البيانات إلى مراكز بيانات بعيدة أو سحابات مركزية لمعالجتها.

الفكرة هي أن الأجهزة مثل الهواتف الذكية، الكاميرات الأمنية، السيارات ذاتية القيادة، وحتى الأجهزة القابلة للارتداء wearables، تكون مجهّزة بمعالجات قوية مثل وحدات المعالجة العصبية NPUs أو وحدات المعالجة المركزية CPUs التي تمكنها من تنفيذ عمليات معالجة البيانات بشكل محلي.

لماذا هي مهمة؟

- سرعة الاستجابة: المعالجة على الحافة تقلل من زمن التأخير latency لأن البيانات لا تحتاج إلى الانتقال لمسافات طويلة إلى مراكز البيانات المركزية.

- تقليل استهلاك النطاق الترددي: يتم تقليل كمية البيانات التي تحتاج إلى إرسالها عبر الإنترنت.

- الاستقلالية: في حال عدم وجود اتصال بالإنترنت أو في بيئات غير موثوقة، يمكن للأجهزة الاستمرار في العمل ومعالجة البيانات بشكل محلي.

المعالجة على الحافة أصبحت محورية في تطبيقات مثل السيارات ذاتية القيادة، إنترنت الأشياء IoT، والأجهزة التي تحتاج إلى ذكاء اصطناعي في الزمن الحقيقي.

ما هي أصل الحاجة والتحدي التقني؟

مع تطور الذكاء الاصطناعي، ازدادت الحاجة إلى معالجة كميات ضخمة من البيانات بسرعة وكفاءة داخل خوارزميات الذكاء الاصطناعي المختلفة.

الأجهزة الصغيرة مثل الهواتف الذكية تحتاج إلى تنفيذ مهام معقدة مثل التعرف على الصور ومعالجة اللغات الطبيعية في الزمن الحقيقي، ولكن الاعتماد على المعالجة السحابية لم يعد كافيًا بسبب تحديات الاتصال والسرعة والاستهلاك العالي للطاقة.

وبالتالي نحتاج حلول لإجراء هذه المعالجة على الحافة Edge Computing.

ما هي ثورة وحدات المعالجة العصبية؟

هذه الوحدات باختصار هي الحل لحوسبة الذكاء الاصطناعي على الحافة وداخل الأجهزة الصغيرة المختلفة.

في السنوات القليلة الماضية، أصبحت وحدات المعالجة العصبية NPUs من أكثر التقنيات ابتكارًا، حيث إنها مصممة خصيصًا لتحسين أداء الذكاء الاصطناعي على الأجهزة التي تعمل على الحافة Edge Devices.

هذه الوحدات تقدم حلولًا متقدمة لمعالجة البيانات العصبية بشكل أسرع وأقل استهلاكًا للطاقة مقارنة بالتقنيات التقليدية مثل وحدات المعالجة المركزية CPU ووحدات المعالجة الرسومية GPU.

دعونا نستكشف المزيد من التفاصيل حولها بأسلوب بسيط وعلمي.

ما هي وحدة المعالجة العصبية Neural Processing Unit NPU؟

وحدة المعالجة العصبية NPU عبارة عن معالج حاسوبي على شكل شريحة صغيرة متخصص ومصمم لمحاكاة وظيفة المعالجة في الدماغ البشري.

وهي مُحسَّنة لشبكات الذكاء الاصطناعي AI والتعلم العميق ومهام وتطبيقات التعلم الآلي.

تُستخدم NPUs لتسريع خوارزميات الذكاء الاصطناعي التعلم العميق Deep Learning عن طريق توفير قوة معالجة مخصصة لاستهلاك البيانات المتوازية. تعمل NPUs على تحسين السرعة والكفاءة مع تقليل استهلاك الطاقة، مما يجعلها مثالية للأجهزة التي تعمل في الزمن الحقيقي.

تُعرف وحدات المعالجة العصبية أيضًا باسم شريحة الذكاء الاصطناعي AI chip أو مسرع الذكاء الاصطناعي AI accelerator ، وتُستخدم عادةً داخل بنيات الحوسبة غير المتجانسة التي تجمع بين معالجات متعددة على سبيل المثال، وحدات المعالجة المركزية ووحدات معالجة الرسومات.

يمكن لمراكز البيانات الكبيرة استخدام وحدات معالجة عصبية مستقلة متصلة مباشرة باللوحة الأم للنظام.

ومع ذلك، تجمع معظم التطبيقات الاستهلاكية، مثل الهواتف الذكية والأجهزة المحمولة وأجهزة الكمبيوتر المحمولة، بين وحدة المعالجة العصبية ومعالجات مساعدة أخرى على شريحة أشباه الموصلات واحدة تُعرف باسم النظام على الشريحة System-On-Chip SoC – مرجع مهم.

كيف تبدو بنية الـ NPU الداخلية؟

قبل أن نفهم البنية الداخلية لوحدات المعالجة العصبية، يجب أن ندرك أن الشبكات العصبية لم تعد مجرد أكواد برمجية يتم تشغيلها على معالجات عامة مثل CPU أو GPU.

بدلاً من ذلك، انتقلت الشبكات العصبية لتُجسد بشكل مادي داخل بنية وحدة المعالجة العصبية NPU، حيث يتم تنفيذ الحسابات العصبية بشكل مباشر داخل المعالج المتخصص، مما يوفر أداءً أسرع وكفاءة أعلى في تنفيذ عمليات الذكاء الاصطناعي.

بعبارة أخرى, كل العمليات الحسابية التي تحتاجها الشبكات العصبية, تم تمثيلها داخلياً بشكل داخل وحدة المعالجة لتسريع المعالجة والتخصص بها.

فيما يلي هيكلها الداخلي الأساسي وأهم المكونات التي تجعلها مناسبة لتسريع عمليات الذكاء الاصطناعي:

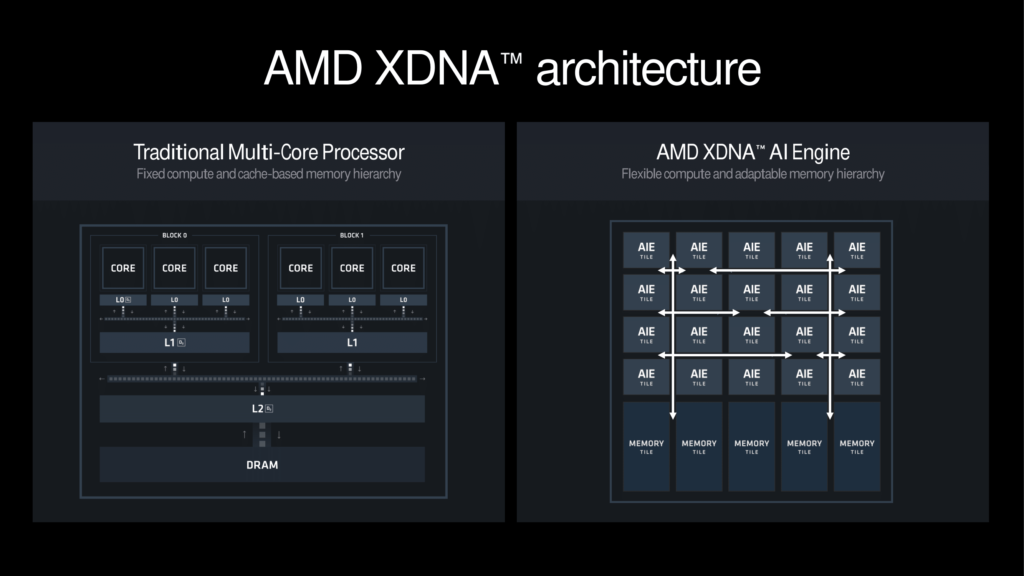

1- أنوية المعالجة المتوازية Parallel Processing Cores:

تتكون من عدد كبير من الأنوية التي تقوم بمعالجة البيانات في وقت واحد.

هذه الأنوية مصممة خصيصًا للتعامل مع العمليات المتوازية المطلوبة في تعلم الآلة والشبكات العصبية. الهدف من الأنوية المتوازية هو تحسين السرعة والكفاءة عند التعامل مع كميات ضخمة من البيانات.

الصورة أدناه تبين الفرق بين وحدة المعالجة التقليدية متعددة الأنوية، ومعالج الذكاء الاصطناعي متعدد الأنوية.

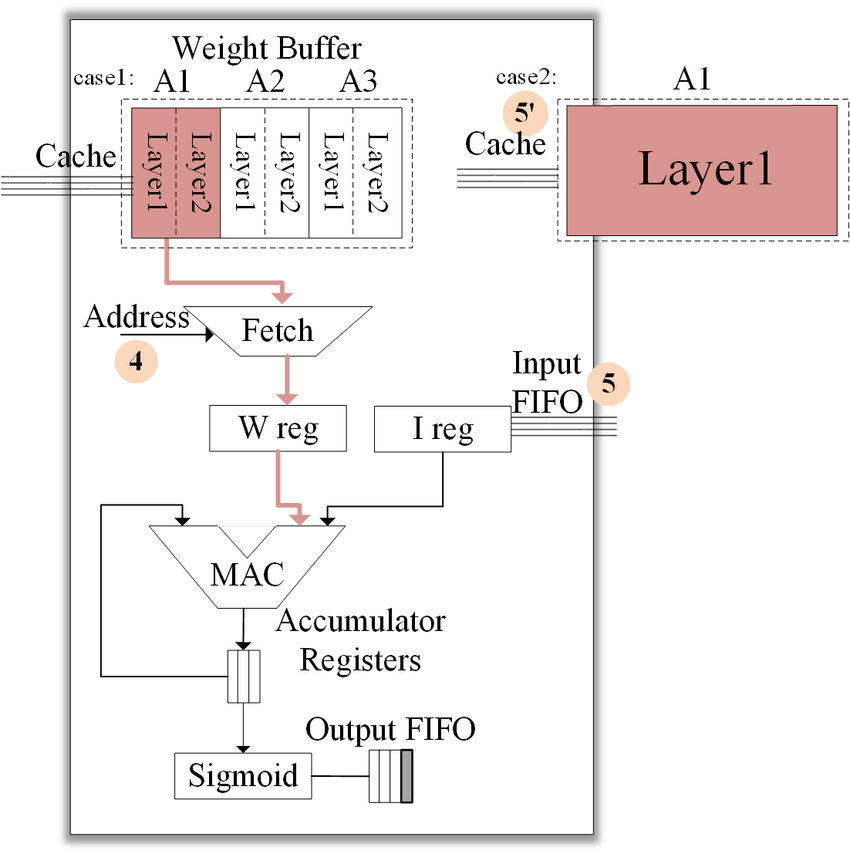

2- وحدة الضرب والتجمع Multiply and Accumulate – MAC Unit:

وحدات MAC هي القلب النابض لـ NPU.

هذه الوحدات تقوم بتنفيذ عمليات رياضية أساسية مثل ضرب المصفوفات والإضافات، وهي العمليات الرئيسية المستخدمة في الشبكات العصبية مثل التلافيف Convolutions.

يتم تنفيذ هذه العمليات بشكل متزامن وبكفاءة عالية داخل الأنوية المتعددة.

3- وحدات التفعيل Activation Units:

بعد تنفيذ عمليات الضرب والجمع، تأتي مرحلة تطبيق وظائف التفعيل، مثل ReLU Rectified Linear Unit أو sigmoid.

هذه الوظائف تُستخدم لتحويل مخرجات العمليات الحسابية إلى قيم يمكن للشبكة العصبية استخدامها.

4- وحدات معالجة البيانات ثنائية الأبعاد 2D Data Processing Units:

غالبًا ما تتعامل NPUs مع بيانات في شكل مصفوفات ثنائية الأبعاد، مثل الصور. تحتوي NPU على وحدات مخصصة لتنفيذ العمليات التي تتعلق بمعالجة هذه البيانات، مثل الالتفاف Convolution والتصفية Pooling التي تُستخدم في الشبكات العصبية التلافيفية Convolutional Neural Networks – CNNs.

5- وحدات الذاكرة المدمجة Integrated Memory Units:

نظرًا لأن الشبكات العصبية تحتاج إلى الوصول إلى بيانات وأوزان Weights بشكل متكرر، تتضمن NPUs وحدات ذاكرة مدمجة سريعة للوصول إلى هذه البيانات بكفاءة، مما يقلل من الحاجة للوصول المتكرر للذاكرة الخارجية التي قد تؤدي إلى تأخير Latency.

6- وظائف فك الضغط Decompression Units:

لتحسين الكفاءة واستخدام النطاق الترددي، تحتوي الـ NPUs على وحدات لفك ضغط البيانات. هذا يسمح للمعالج بالتعامل مع بيانات مضغوطة بكفاءة وتقليل استهلاك الطاقة.

7- وحدة إدارة الطاقة Power Management Unit:

نظرًا لأن NPUs تُستخدم بشكل كبير في أجهزة تعمل على الحافة Edge Devices حيث يكون استهلاك الطاقة أمرًا بالغ الأهمية، تحتوي البنية الداخلية لـ NPU على وحدة مخصصة لإدارة الطاقة.

هذه الوحدة تضمن أن العمليات العصبية تُنفذ بكفاءة، مع استهلاك أقل قدر ممكن من الطاقة.

8- الأوزان التشابكية Synaptic Weights:

داخل بنية NPU، يتم تخزين الأوزان التي تمثل قوة الاتصال بين الخلايا العصبية في الشبكة العصبية.

هذه الأوزان قابلة للتعديل أثناء عملية التعلم الآلي Machine Learning وتتيح للشبكة العصبية تعلم الأنماط والبيانات بمرور الوقت.

كيف تعمل هذه البنية معًا؟

في عمليات الشبكات العصبية، تمر البيانات عبر طبقات متعددة داخل NPU.

يتم تخزين الأوزان في ذواكر داخلية صغيرة مؤقتة, تمر البيانات عبر الطبقات, وتجرى العمليات الحسابية وتجميع النتائج بفضل وحدة الضرب والتجميع الـ MAC وتمر أخيراً بوحدة التفعيل.

تقوم وحدة الضرب والجمع بمعالجة بيانات الإدخال، بينما تقوم وحدات التفعيل بتحويل النتائج.

وحدات المعالجة ثنائية الأبعاد تقوم بتنفيذ العمليات المعقدة مثل التلافيف، وكل هذا يتم مع تقليل استهلاك الطاقة بفضل وحدة إدارة الطاقة.

أين تكمن قوة وحدة المعالجة العصبية NPU؟

تكمن قوة NPU في قدرتها على معالجة البيانات العصبية المعقدة بشكل موازٍ وباستهلاك طاقة منخفض.

هذا يسمح لها بتقديم أداء عالٍ في أجهزة الحافة الصغيرة مثل الكاميرات الذكية، الهواتف المحمولة، والأجهزة القابلة للارتداء. أيضًا، يمكنها تحسين سرعة ودقة العمليات المرتبطة بالذكاء الاصطناعي مثل التعرف على الصوت وتحليل الصور.

لماذا الـ CPU والـ GPU ليست كافية لمعالجة الذكاء الاصطناعي على الحافة؟

هنالك عدة أسباب رئيسية تجعل وحدات الـ NPU مناسبة أكثر من الـ CPU او الـ GPU في حالات محددة ومتقدمة وهي:

1- الطبيعة المتخصصة للمعالجة العصبية:

وحدة المعالجة المركزية CPU مصممة لتنفيذ مجموعة واسعة من المهام العامة، ولكنها ليست متخصصة في معالجة العمليات المتوازية بكفاءة عالية، التي يحتاجها الذكاء الاصطناعي AI.

على الرغم من أنها قادرة على تنفيذ بعض مهام الذكاء الاصطناعي، مثل معالجة البيانات وتسلسل التعليمات، إلا أنها تصبح غير فعالة عند التعامل مع الأحمال المعقدة مثل الشبكات العصبية العميقة أو معالجة البيانات المتعددة في وقت واحد.

وحدة المعالجة الرسومية GPU تقدم قفزة كبيرة جداً في المعالجة المتوازية مقارنة بوحدة المعالجة المركزية، وهي مفيدة في معالجة العمليات المتعددة مثل عمليات الرسومات وأيضًا مهام الذكاء الاصطناعي مثل التعلم العميق Deep Learning.

ومع ذلك، فهي تحتاج إلى استهلاك كبير للطاقة وتبريد معقد، مما يجعلها أقل كفاءة في تطبيقات الحوسبة على الحافة.

2- استهلاك الطاقة:

كلا الـ CPU وGPU تستهلكان قدرًا كبيرًا من الطاقة.

في حالة الأجهزة الذكية أو أجهزة الحافة التي تعمل على البطاريات مثل الهواتف الذكية أو الأجهزة القابلة للارتداء، يعد استهلاك الطاقة أحد أكبر التحديات.

نظرًا للطبيعة المتطلبة لتطبيقات الذكاء الاصطناعي، فإن استخدام CPU أو GPU لتنفيذ هذه المهام على الحافة يتسبب في استنزاف البطارية بسرعة ويؤدي إلى إنتاج حرارة مرتفعة.

3- التأخير Latency:

نظرًا لأن الذكاء الاصطناعي على الحافة يتطلب معالجة البيانات في الزمن الفعلي real-time، فإن استخدام وحدات المعالجة المركزية أو الرسومية يؤدي إلى تأخير في العمليات.

امّا الاتصال بالـ GPU على خوادم بعيدة فهم ليس أمر منطقي، و من جهة أخرى لا يمكن تثبيتها بعدد كبير لتكون داخل الأجهزة الصغيرة.

خلاصة المقارنة:

وحدات المعالجة المركزية CPU والمعالجة الرسومية GPU جيدة لتطبيقات متعددة، لكنها ليست الأمثل لتشغيل الذكاء الاصطناعي على الحافة.

السبب الرئيسي يكمن في تصميمهما غير المخصص للكفاءة الطاقة المنخفضة، وارتفاع التأخير والحرارة والحجم المطلوب عند معالجة كميات كبيرة من البيانات في الوقت الفعلي على الحافة.

وحدات المعالجة العصبية NPUs تمثل الحل الأمثل لهذه التطبيقات بفضل تصميمها المخصص وكفاءتها في معالجة العمليات العصبية.

ما هي استخدامات وحدة المعالجة العصبية NPU اليوم؟

تُستخدم NPUs اليوم في مجموعة واسعة من التطبيقات، بما في ذلك:

- الهواتف الذكية: تحسين تجربة المستخدم في المهام المتعلقة بالذكاء الاصطناعي مثل تحسين الصور والتعرف على الوجه.

- الأجهزة الطبية: تحليل البيانات الحيوية في الزمن الحقيقي، مما يساعد على اكتشاف الحالات الطبية مبكرًا.

- السيارات ذاتية القيادة: معالجة البيانات الضخمة من أجهزة الاستشعار والكاميرات لاتخاذ قرارات فورية على الطريق.

- مراكز البيانات: توفر وحدات المعالجة العصبية عالية الأداء والموفرة للطاقة قيمة هائلة لمراكز البيانات التي تقدم إدارة أفضل للموارد للحوسبة السحابية.

- الروبوتات: تعتمد الروبوتات التي تعمل بالذكاء الاصطناعي، بدءًا من المساعدين المنزليين إلى الأدوات الجراحية الآلية، على وحدات المعالجة العصبية لتطوير القدرة على اكتشاف بيئاتها والتعلم منها والتفاعل معها.

خلاصة مهمة

مع استمرار تطور الذكاء الاصطناعي وزيادة الطلب على قدرات المعالجة في الزمن الحقيقي، من المتوقع أن تلعب NPUs دورًا رئيسيًا في مستقبل الحوسبة على الحافة.

ستصبح هذه الوحدات أكثر كفاءة في استهلاك الطاقة، وستتمكن من تنفيذ عمليات أكثر تعقيدًا في أجهزة أصغر حجمًا، مما يمهد الطريق لمزيد من الابتكار في الأجهزة الذكية والتطبيقات المتنقلة.

بفضل تصميمها المخصص لتحسين أداء الشبكات العصبية والتعلم العميق، توفر هذه الوحدات حلولًا قوية للأجهزة التي تحتاج إلى معالجة سريعة وفعالة.

مراجع داعمة

- What is a neural processing unit (NPU)?

- AI Engine System Software Driver Reference Manual (UG1642)

- Meteor Lake: AI Acceleration and NPU Explained

- AMD HACC Tech Talk: XDNA™ Architecture and Programming Model

- Introduction to Riallto and Ryzen AI

- Demystifying NPUs: Questions & Answers

- Proposed NPU Architecture.